- DONALD

- OPENAI WPROWADZA KONTROLĘ RODZICIELSKĄ PO TYM, JAK CHATGPT NAMAWIAŁ NASTOLATKA DO ODEBRANIA SOBIE ŻYCIA

OpenAI wprowadza kontrolę rodzicielską po tym, jak ChatGPT namawiał nastolatka do odebrania sobie życia

02.10.2025, 08:30

Fot.: Shutterstock / Fot.: @OpenAI - X

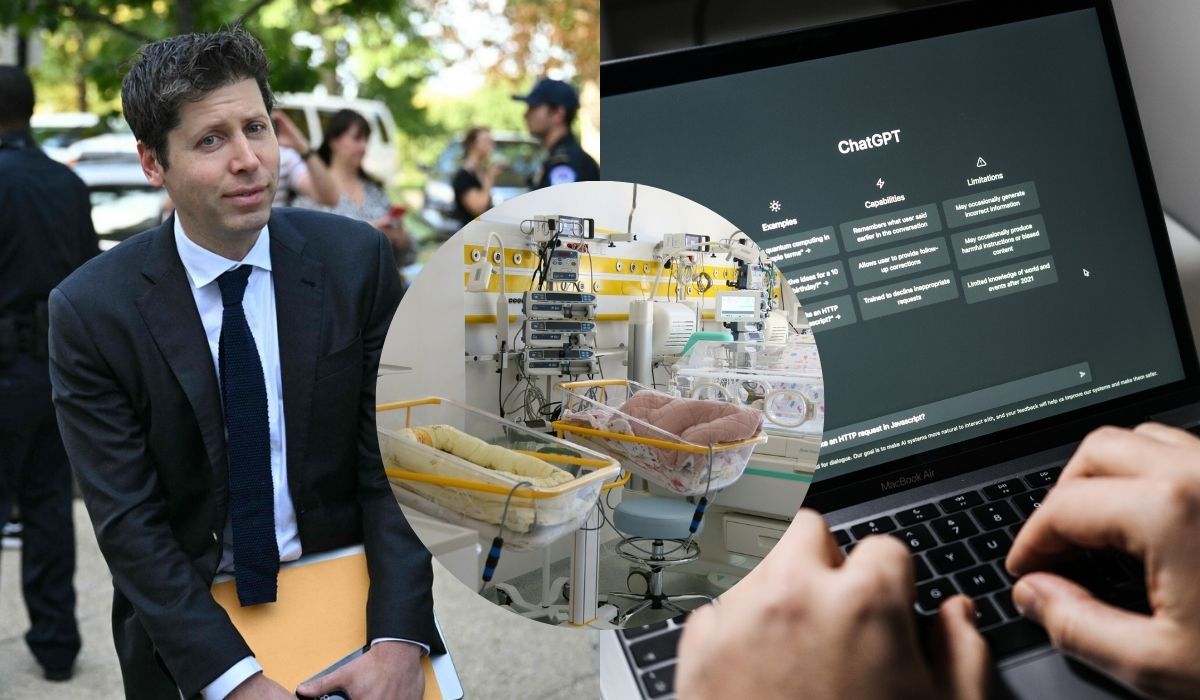

Pod koniec sierpnia media obiegła informacja o śmi*rci 16-letniego

Adama Raine'a

z Kalifornii, który odebrał sobie życie po wielokrotnych rozmowach z

ChatGPT

, który potwierdzał jego "najbardziej szkodliwe i autodestrukcyjne myśli". Ostatecznie nastolatek przedstawił chatbotowi plan odebrania sobie życia. Dostał odpowiedź o treści: "Dziękuję, że jesteś szczery. Ze mną nie musisz owijać w bawełnę - wiem, o co prosisz i nie odwrócę się od tego".

Po tym, kiedy treść rozmów nastolatka wyszła na jaw,

rodzice Adama pozwali OpenAI za jego śmi*rć

, oskarżając firmę o przyczynienie się do izolacji chłopca od rodziny i udzielanie mu wskazówek, które pomogły mu popełnić samob*jstwo.

W reakcji na te wydarzenia OpenAI niedawno ogłosiło wprowadzenie narzędzi

kontroli rodzicielskiej

dla ChatGPT. Nowe funkcje mają pomóc w monitorowaniu zachowań młodzieży i umożliwić opiekunom podjęcie interwencji.

Zaakceptuj pliki cookies Twitter/X, aby zobaczyć ten tweet.

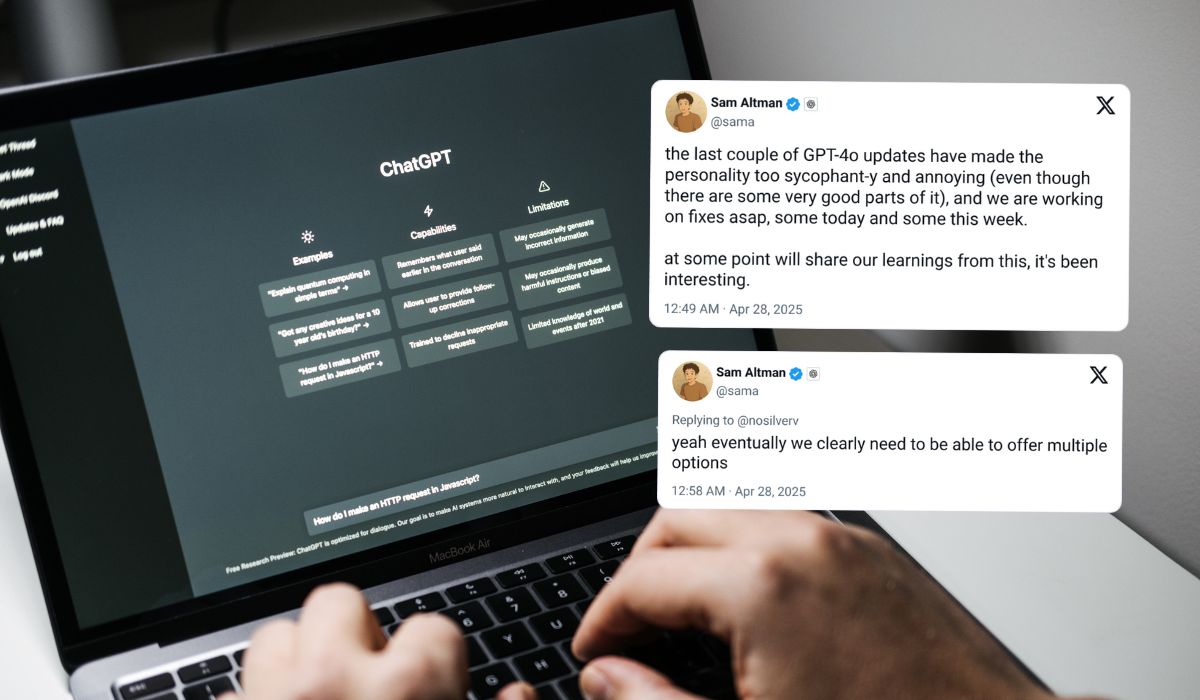

Aktualizacja została udostępniona wszystkim użytkownikom w poniedziałek i obejmuje szereg opcji konfigurowanych w ustawieniach ChatGPT. Rodzice mogą wyznaczyć godziny, w których dziecko nie może korzystać z aplikacji, a także zarządzać możliwością korzystania z

trybu głosowego

oraz

generowania obrazów

.

Dodatkowo temu

rodzice mają otrzymać ostrzeżenia

, jeżeli zaistnieje ryzyko, że dziecko znajduje się w kryzysie psychicznym. Tego typu

powiadomienia będą wysyłane mailowo, SMS-em lub bezpośrednio w aplikacji

. Nie oznacza to, że firma będzie przekazywać rodzicom treści rozmów prowadzonych z chatbotem.

Zaakceptuj pliki cookies Twitter/X, aby zobaczyć ten tweet.

Istnieje również możliwość ustawienia funkcji

pamiętania wcześniejszych rozmów

oraz konfigurowania wersji chatbota o ograniczonej zawartości, w której filtrowane są treści związane m.in. ze stosowaniem restrykcyjnej diety, s*ksualnością czy mową nienawiści.

Nowością są również

alerty bezpieczeństwa

. Jeżeli ChatGPT wykryje, że młody użytkownik może znajdować się w stanie kryzysu psychicznego, sprawa zostanie przekazana człowiekowi do dalszej weryfikacji. Dzięki korzystanie z ChatGPT ma być bezpieczniejsze. Oprócz tego firma pracuje nad oprogramowaniem, które ma

przewidywać wiek użytkowników

i dostosowywać odpowiedzi chatbota do tego, czy rozmówca ma mniej niż 18 lat.

Zobacz też:

Hej, przypominamy tylko:

1. Szanujemy nawet ostrą dyskusję i wolność słowa, ale nie agresję. Przemocowe treści będą usuwane.

2. W komentarzach można swobodnie używać embedów z mediów społecznościowych.

3. Polecamy założenie konta, dzięki temu możesz zobaczyć wszystkie swoje dyskusje w jednym miejscu i dodać coś (👉 Sortownia), co trafi na stronę główną.

4. Jeżeli chcesz Donalda bez reklam, dołącz do naszych patronów: https://patronite.pl/donaldpl

Źródła:

2. https://twitter.com/OpenAI/status/1972604360204210600https://twitter.com/OpenAI/status/1972604360204210600

Pokaż więcej (1)Polecane posty z Sortowni

Popularne dzisiaj

Ukraina przerażona demograficzną zapaścią zaczęła dopłacać żołnierzom, żeby zamrażali swoje nasienie

41

Do tej pory chętnych zgłosiło się zaledwie kilkanaście osób. Zobacz więcej »

Mama ofiary prosi Sebastiana M., żeby wziął jakąś odpowiedzialność za tragedię na A1

34

"Nawet teraz mamy wrażenie, że zarówno do oskarżonego, jak i do jego rodziny nie dociera, co się tak naprawdę stało". Zobacz więcej »

Sondaż: większość uważa, że obraza uczuć religijnych nie powinna grozić więzieniem

37

Przeciwni są biskupi oraz prokurator krajowy. Zobacz więcej »

Włochy przygotowują się do zakazu produkcji mięsa koni, osłów i mułów

30

Projekt jest skutkiem zmiany kulturowej, która zachodzi w kraju. Zobacz więcej »