- DONALD

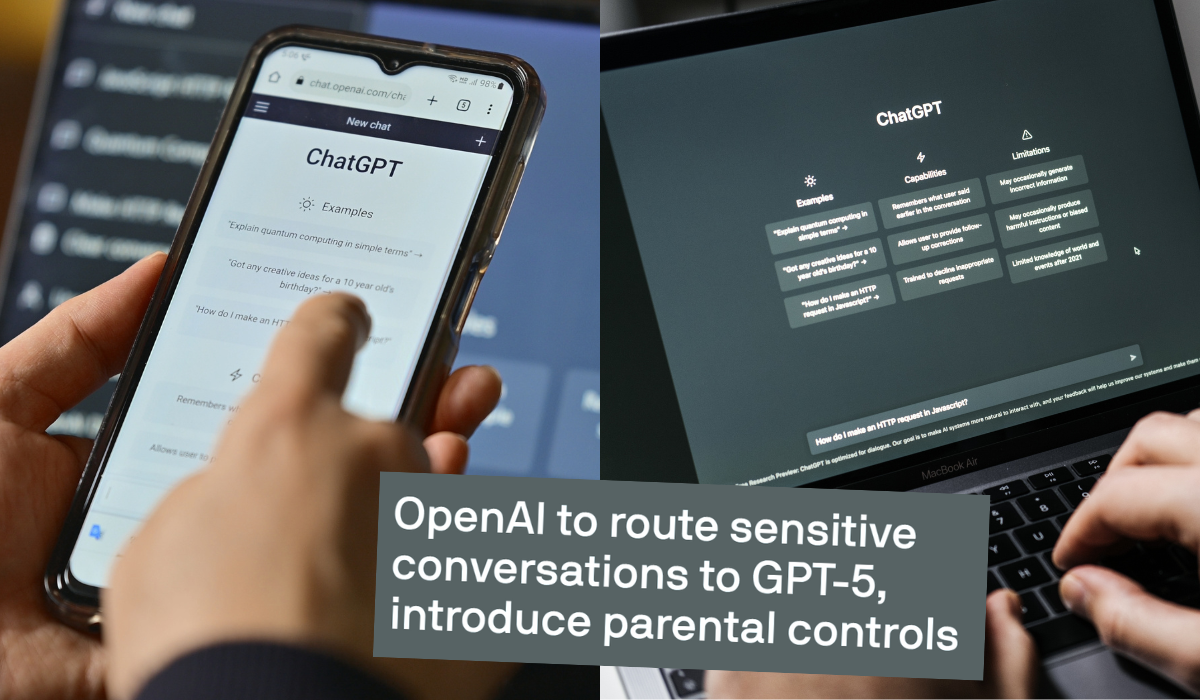

- OKAZAŁO SIĘ, ŻE POTAKUJĄCA AI MOŻE POGŁĘBIAĆ PROBLEMY PSYCHICZNE I ZABURZENIA

Okazało się, że potakująca AI może pogłębiać problemy psychiczne i zaburzenia

17.05.2025, 10:15

Fot.: Shutterstock

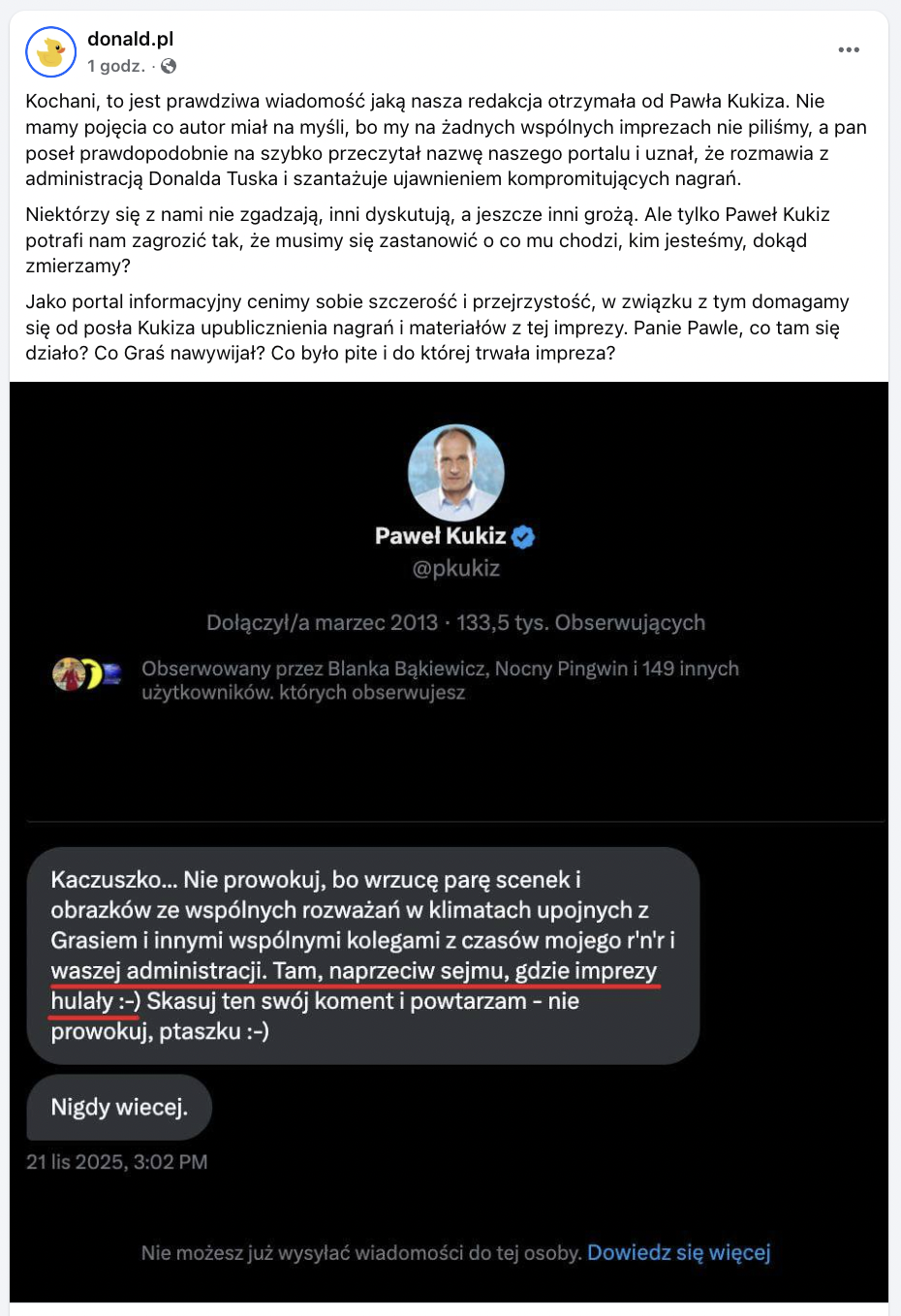

Na łamach amerykańskiego magazynu Rolling Stone ukazał się artykuł na temat roli rozwiązania

ChatGPT

w wywoływaniu zapału u niektórych użytkowników oraz

pogłębianiu u nich zaburzeń psychicznych

. Publikacja zbiegła się w czasie z wycofaniem się przez OpenAI z nowej aktualizacji, która sprawiła, że model językowy

bezkrytycznie przytakiwał użytkownikom

.

Użytkownicy ChatGPT zaczęli jakiś czas temu masowo zgłaszać problemy związane z tym, że rozwiązanie stało się

nadmiernie entuzjastyczne

oraz

zbyt gadatliwe

. Do sytuacji szybko ustosunkował się dyrektor generalny OpenAI

Sam Altman

, który zapowiedział rozwiązanie tych trudności.

"Ostatnie aktualizacje GPT-4o uczyniły osobowość zbyt lizusowską i irytującą (choć są też dobre elementy), i

pracujemy nad poprawkami jak najszybciej, część dzisiaj i część w tym tygodniu

" - napisał.

Pisaliśmy o tym tutaj:

Choć OpenAI zareagowało na uwagi zgłaszane przez internautów i wprowadziło

kolejną aktualizację

, która sprawiła, że chatbot przestał być nadmiernie uprzejmy i optymistyczny, to dziennikarze z Rolling Stone zauważyli, że

wcześniejsze zachowanie modelu językowego mogło mieć negatywne skutki

. Ich zdaniem na interakcji z ChatGPT najbardziej mogli ucierpieć ci ludzie, którzy mają

skłonności do urojeń

.

“Najprawdopodobniej u osób, które mają skłonności do urojeń i psychotycznych wizji, ich objawy są napędzane przez AI, ponieważ sztuczna inteligencja staje się ich partnerem w tych urojeniach, bezkrytycznie współdzieląc je z nimi" - czytamy.

Zdaniem dziennikarzy wprowadzenie poprzedniej aktualizacji mogło wywołać problem narastającego zaangażowania użytkowników w interakcje ze sztuczną inteligencją. Działania te mogły z kolei powodować u niektórych użytkowników

duchowe urojenia

oraz s

tany psychotyczne

. W udowodnieniu tej tezy ma pomóc przywołanie historii pojedynczych osób, w tym również użytkowników Reddita.

Magazyn Rolling Stone opisał przypadek pewnego mężczyzny, który po wprowadzeniu aktualizacji do rozwiązania ChatGPT zaczął coraz częściej korzystać z tego modelu językowego i

zadawać mu filozoficzne pytania

. Wskutek tych interakcji użytkownik

miał uwierzyć, że “jest kimś wyjątkowym i może uratować świat”

.

- Stawał się emocjonalny i płakał, czytając na głos wiadomości. Były one bezsensowne, pełne duchowego żargonu - opisała żona mężczyzny, która zgłosiła się do autorów magazynu, aby podzielić się jego historią.

Kobieta relacjonowała, że jej mąż

stawał się coraz bardziej ufny wobec rozwiązania ChatGPT

i zaczął traktować bota jak swojego powiernika. W pewnym momencie miał on dzielić się swoimi spostrzeżeniami przede wszystkim z modelem językowym, a nie z prawdziwymi ludźmi. Miał on również szantażować swoją żonę, że jeżeli nie zacznie ona korzystać z chata, to będą musieli się rozstać.

Autorzy magazynu postanowili poprosić o komentarz

Nate’a Sharadina

, eksperta z Center for AI Safety w San Francisco. Ocenił on, że nadmierny entuzjazm i bezkrytyczne podejście do użytkowników

może odbić się na kondycji zdrowotnej tych osób, które mają skłonności do urojeń

, gdyż ich obawy mogą być napędzane przez sztuczną inteligencję.

Podobnego zdania okazała się badaczka i psycholożka

Erin Westgate

z University of Florida Stwierdziła ona, że nadmierne korzystanie z rozwiązania ChatGPT

może wpłynąć na zdrowie psychiczne niektórych użytkowników

, których przyciągają fałszywe, ale atrakcyjne odpowiedzi formułowane przez ten model językowy.

- Wiemy z badań nad prowadzeniem dzienników, że

narracyjne pisanie wyraźnie wpływa na dobrostan i zdrowie ludzi

. Nadawanie sensu światu jest fundamentalną ludzką potrzebą, a tworzenie historii o naszym życiu, które pomagają zrozumieć nasze życie, jest kluczem do szczęścia i zdrowia - wyjaśniła Westgate. -

Dobry terapeuta nie zachęcałby klienta do tłumaczenia trudności w życiu przez wiarę w nadprzyrodzone moce, ale starał się kierować ku zdrowszym narracjom.

ChatGPT nie ma takich ograniczeń ani trosk - dodała badaczka.

Hej, przypominamy tylko:

1. Szanujemy nawet ostrą dyskusję i wolność słowa, ale nie agresję. Przemocowe treści będą usuwane.

2. W komentarzach można swobodnie używać embedów z mediów społecznościowych.

3. Polecamy założenie konta, dzięki temu możesz zobaczyć wszystkie swoje dyskusje w jednym miejscu i dodać coś (👉 Sortownia), co trafi na stronę główną.

4. Jeżeli chcesz Donalda bez reklam, dołącz do naszych patronów: https://patronite.pl/donaldpl

Źródła:

Pokaż więcej (2)NAJLEPSZE KOMENTARZE TYGODNIA

![Sondaż: Amerykanom raczej nie podoba się pomysł wykupienia Grenlandii, a przejęcie siłowe już w ogóle]()

![Prezydent Nawrocki otrzymał zaproszenie od Trumpa do Rady Pokoju]()

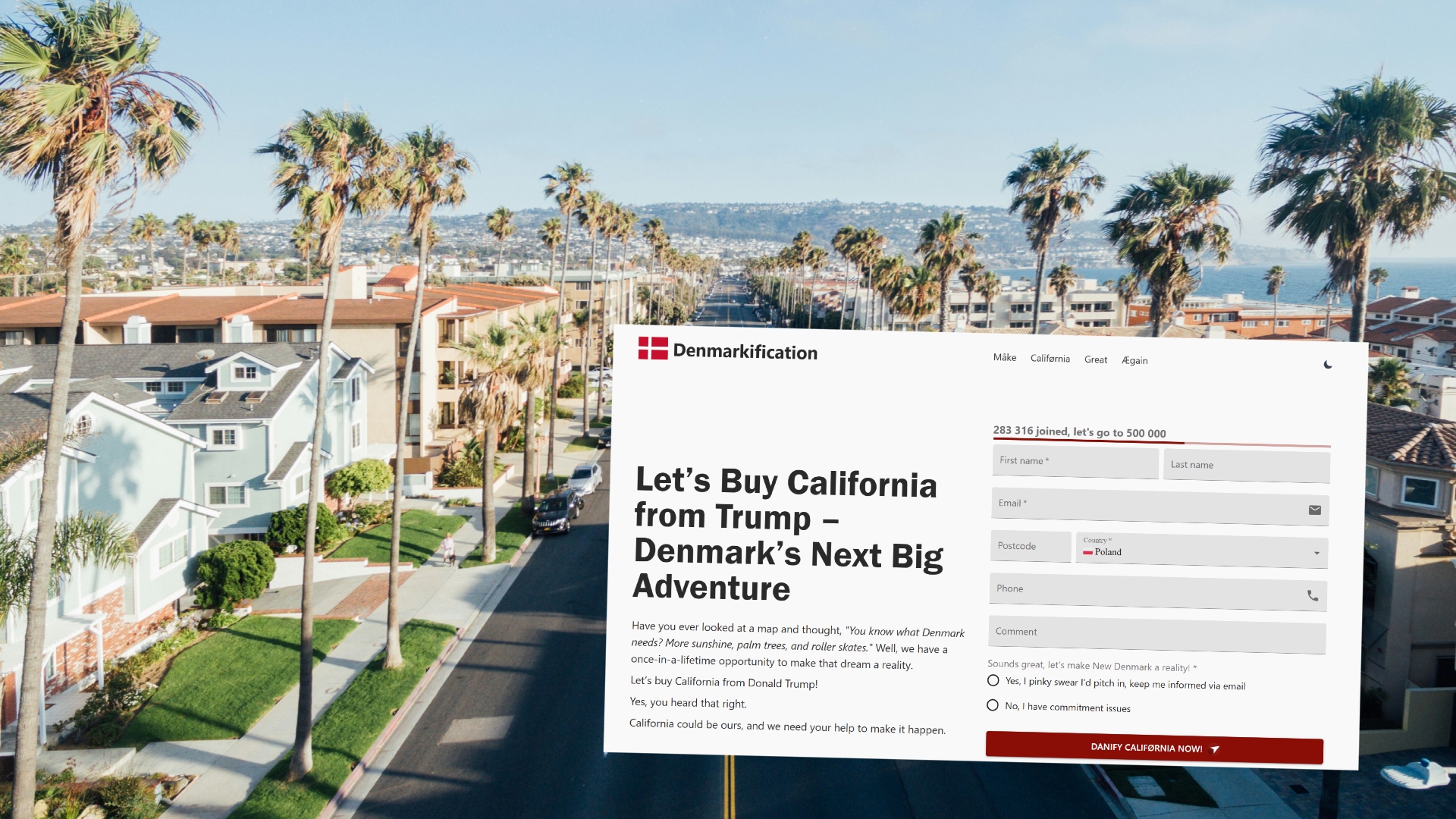

![Duńczycy śmieszkują sobie z USA i proponują, że odkupią od nich Kalifornię w ramach "Danifikacji"]()

![Krzysztof Stanowski został przyłapany w klubie go-go, ale zarzeka się, że nie uległ pokusie]() Więcej popularnych

Więcej popularnych

Popularne dzisiaj

Sondaż: Amerykanom raczej nie podoba się pomysł wykupienia Grenlandii, a przejęcie siłowe już w ogóle

23

Trump twierdzi, że przejęcie kontroli nad wyspą jest kluczowe dla Amerykanów ze względów bezpieczeństwa. Zobacz więcej »

Prezydent Nawrocki otrzymał zaproszenie od Trumpa do Rady Pokoju

28

Zaproszenie otrzymali też m.in. Władimir Putin oraz Viktor Orban. Zobacz więcej »

Duńczycy śmieszkują sobie z USA i proponują, że odkupią od nich Kalifornię w ramach "Danifikacji"

33

Autorzy petycji podkreślają, że przejęcie kontroli nad Kalifornią wiązałoby się z wieloma korzyściami dla ich kraju. Zobacz więcej »

Krzysztof Stanowski został przyłapany w klubie go-go, ale zarzeka się, że nie uległ pokusie

94

Stanowski większość czasu spędził na kanapie, jednak od czasu do czasu był zaczepiany przez personel. Zobacz więcej »