- DONALD

- USA: POLICYJNY RAPORT ZAWARŁ INFORMACJĘ O ZAMIANIE FUNKCJONARIUSZA W ŻABĘ, BO W TLE INTERWENCJI LECIAŁA BAJKA

USA: policyjny raport zawarł informację o zamianie funkcjonariusza w żabę, bo w tle interwencji leciała bajka

19.01.2026, 07:00

Fot. East News / Disney, Motion Picture Association of America

Telewizja Fox donosi o policyjnym raporcie wygenerowanym przez sztuczną inteligencję, w którym było napisane, że

pewien funkcjonariusz z Utah w zeszłym miesiącu zamienił się w żabę

. Zdaniem stacji niefortunne określenie zostało zamieszczone w dokumencie za sprawą

testów oprogramowania Draft One

, które automatycznie generuje raporty policyjne na podstawie nagrań z kamer nasobnych.

Celem wdrożenia tego systemu było

ograniczenie formalności

związanych z przygotowywaniem raportów przez policjantów. Doszło jednak do sytuacji, w której

oprogramowanie błędnie zinterpretowało dźwięk tła

. W efekcie w raporcie znalazła się informacja o tym, że jeden z funkcjonariuszy zamienił się w żabę.

Postępowanie wyjaśniające w tej sprawie wszczął Departament Policji w Heber City. Okazało się, że

w tle odtwarzany był film Disneya

. Chodzi dokładnie o pozycję

Księżniczka i żaba

. Sytuacja pokazała funkcjonariuszom, jak ważne jest weryfikowanie treści raportów generowanych przez AI.

Zaakceptuj pliki cookies Twitter/X, aby zobaczyć ten tweet.

Policjanci zostali natomiast zmuszeni do poprawienia błędnie wygenerowanego dokumentu. Mimo to szacuje się, że dzięki wykorzystaniu technologii zaoszczędzili oni od sześciu do ośmiu godzin pracy tygodniowo.

Po feralnej sytuacji Departament Policji w Heber City rozpoczął testowanie innego systemu opartego na sztucznej inteligencji,

Code Four

. Jest to rozwiązanie, które również generuje raporty policyjne na podstawie nagrań z kamer nasobnych, jednak oczekuje się, że będzie ono bardziej ostrożne w swoich interpretacjach.

Zaakceptuj pliki cookies Twitter/X, aby zobaczyć ten tweet.

Okres testowania Code Four zakończy się w przyszłym miesiącu.

Wówczas okaże się, który system był dokładniejszy i który ostatecznie zostanie wdrożony do rutynowej pracy przez policjantów. Do tej pory funkcjonariusze korzystali z innych narzędzi opartych na sztucznej inteligencji. Mogą one natychmiast powiadamiać detektywów o zgłoszeniu przestępstwa. Dodatkowo niektórzy używają kamer wspomaganych przez AI.

Krytycy tych rozwiązań ostrzegają i apelują o ostrożność

. Podkreślają, że nadmierne zaufanie wobec nowych technologii może utrudnić proces identyfikacji podejrzanych lub wyjaśniania przestępstw. Inni argumentują, że raporty generowane przez sztuczną inteligencję mogą być zakłamane lub mało dokładne.

Zobacz też:

Hej, przypominamy tylko:

1. Szanujemy nawet ostrą dyskusję i wolność słowa, ale nie agresję. Przemocowe treści będą usuwane.

2. W komentarzach można swobodnie używać embedów z mediów społecznościowych.

3. Polecamy założenie konta, dzięki temu możesz zobaczyć wszystkie swoje dyskusje w jednym miejscu i dodać coś (👉 Sortownia), co trafi na stronę główną.

4. Jeżeli chcesz Donalda bez reklam, dołącz do naszych patronów: https://patronite.pl/donaldpl

Źródła:

Pokaż więcej (2)Polecane posty z Sortowni

Popularne dzisiaj

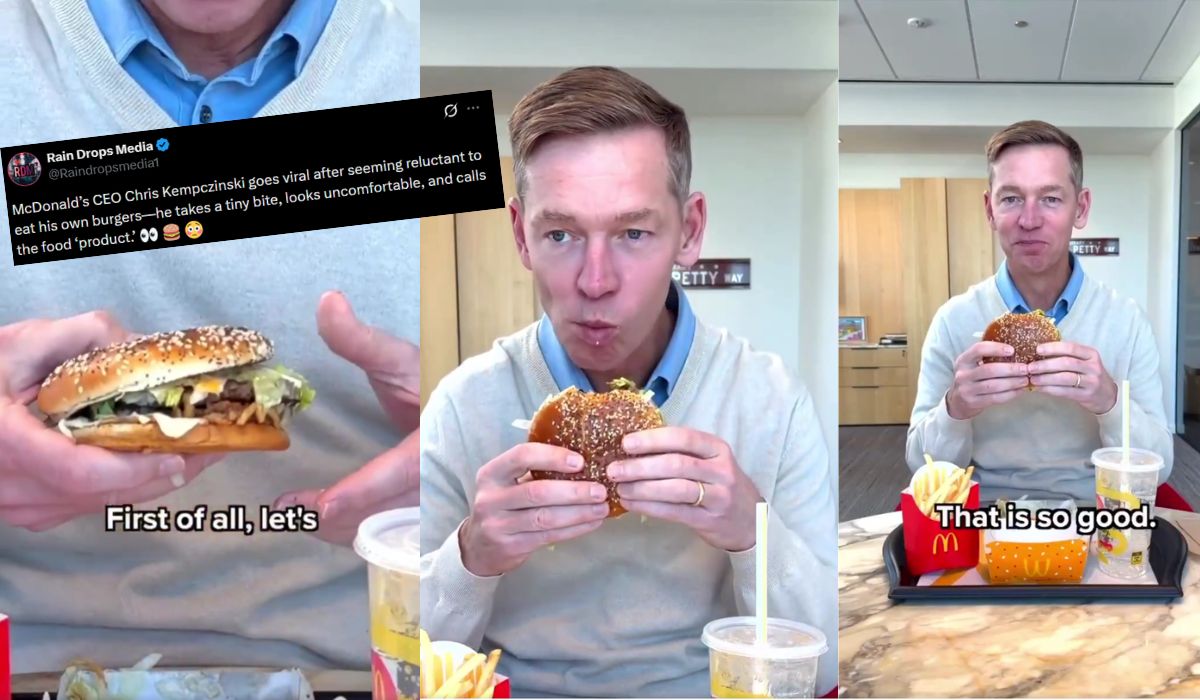

Łukaszenka odwiedził krajową podróbkę McDonald's i chce więcej takich w powiatach

24

Dyktator nigdy wcześniej nie był w fast foodzie. Zobacz więcej »

Sondaż: wybór Przemysława "Srarnka" Czarnka nie został zbyt ciepło przyjęty

44

Pozytywnie ocenia go niecałe 25% badanych. Zobacz więcej »

Warszawa: zatrzymano seryjnego objadacza drogich restauracji, który lubił zjeść, ale nie lubił płacić

24

Łączne straty wyniosły ponad 12 tysięcy zł. Zobacz więcej »

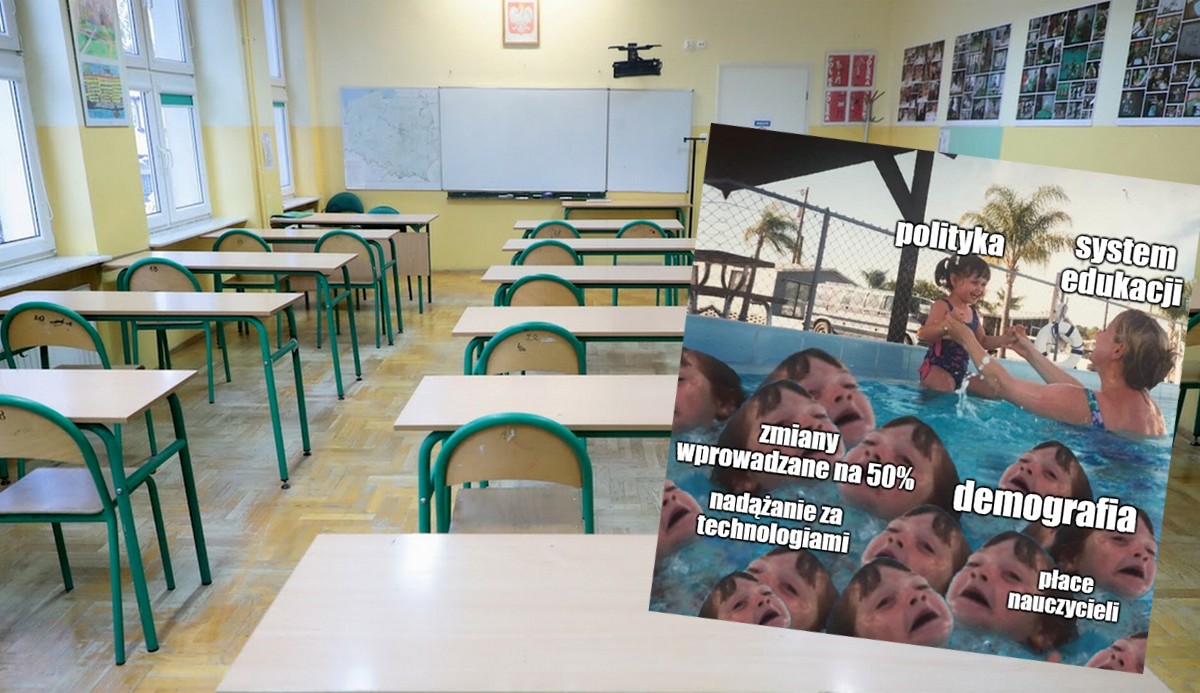

Badanie: poziom nauczania wskazywany jako jeden z największych problemów w polskim systemie edukacji

24

Inne trudności to częste zmiany podstaw programowych czy niskie pensje nauczycieli. Zobacz więcej »