- DONALD

- GUARDIAN: ZDROWOTNE PORADY OD GOOGLE AI BYWAJĄ SZKODLIWE I MYLĄCE

Guardian: zdrowotne porady od Google AI bywają szkodliwe i mylące

04.01.2026, 14:30

Online Marketing - Unsplash / theguardian.com

Śledztwo przeprowadzone przez brytyjski dziennik The Guardian wykazało, że

Przegląd od AI

, oferowany w wyszukiwarce Google, potrafi przedstawiać odbiorcom

nieprawdziwe dane

, wprowadzając ich tym samym w błąd. Tego typu tendencja została zaobserwowana również w przypadkach, kiedy internauci szukali informacji o medycynie.

The Guardian podał, że sam

Google twierdzi, że dane zawarte w Przeglądach od AI są "przydatne" oraz "niezawodne"

. Rozwiązanie, wbudowane w wyszukiwarkę Google, dostarcza użytkownikom opracowania wyszukiwanego tematu, bazując na tym, co algorytmy znajdą w sieci.

Dziennik zauważył, że

Przegląd od AI pojawia się na samej górze wyników wyszukiwani

a. Dopiero przewijając w dół internauci mają możliwość zaczerpnąć informacji z oryginalnych źródeł. Jak wykazało śledztwo The Guardian, w podsumowaniach przygotowanych przez Google pojawiają się

nieprawdziwe informacje

, również na temat zdrowia, narażając ludzi na ryzyko szkody.

Jak czytamy w artykule, w jednym z przypadków przeanalizowanych przez ekspertów Google błędnie zalecił pacjentom onkologicznym zmagającym się z

nowotworem trzustki

unikania pokarmów o wysokiej zawartości tłuszczu. Zdaniem badaczy jest to dokładne przeciwieństwo tego, co zaleca się tej grupie chorych. Dostosowanie się do rad zawartych w Przeglądzie od AI może zwiększać ryzyko zgonu pacjenta.

Zaakceptuj pliki cookies Twitter/X, aby zobaczyć ten tweet.

Jak stwierdziła Anna Jewell, dyrektor ds. wsparcia, badań i wpływu w Pancreatic Cancer UK, zalecanie tej grupie pacjentów unikania produktów o wysokiej zawartości tłuszczu może być szkodliwe. Jak oceniła, ostatecznie może to "zmniejszyć szanse pacjenta na powrót do zdrowia".

- Przegląd od AI sugeruje, że osoby z rakiem trzustki powinny unikać pokarmów wysokotłuszczowych i podaje listę przykładów.

Jeśli jednak ktoś zastosuje się do sugestii z wyników wyszukiwania, może nie przyjmować wystarczającej ilości kalorii

, mieć trudności z przybraniem na wadze i

nie tolerować chemioterapii

ani potencjalnie ratującej życie operacji - tłumaczyła.

- Wiele osób z chorobami wątroby nie wykazuje żadnych objawów aż do późnych stadiów, dlatego tak ważne jest, aby poddać się badaniom. Jednak to, co Przegląd od AI określa jako ‘normalne’, może drastycznie różnić się od tego, co faktycznie uważa się za normalne - dodała Pamela Healy, dyrektor generalna British Liver Trust.

Zaakceptuj pliki cookies Twitter/X, aby zobaczyć ten tweet.

Eksperci zauważyli, że w Przeglądzie od AI oferowanym przez Google znalazły się fałszywe informacje na temat

kluczowych czynności wątroby

oraz tego, jakie objawy ze strony tego organu powinny być niepokojące. Może to sprawić, że osoby zmagające się z chorobami wątroby będą błędnie uważać, że są zdrowe, lub powiążą swój stan z innymi dolegliwościami.

Wątpliwości ekspertów budzą też informacje na temat

raka pochwy

, prezentowane w Przeglądach od AI. Jak zauważyli,

sztuczna inteligencja sugeruje, że odpowiednią metodą na wykrycie tej choroby jest badanie cytologiczne

. Stanowisko ekspertów jest jednak odmienne.

- To nie jest test wykrywający raka, a już na pewno nie jest to test wykrywający raka pochwy. To całkowicie błędna informacja.

Otrzymanie takiej błędnej informacji może potencjalnie doprowadzić do tego, że ktoś nie zgłosi się na badanie pod kątem objawów raka pochwy

, ponieważ jego wynik w niedawnym badaniu przesiewowym szyjki macicy był prawidłowy - mówiła Athena Lamnisos, dyrektor naczelna organizacji charytatywnej Eve Appeal.

- Martwi nas również fakt, że

Przegląd od AI zmieniał się, gdy przeprowadzaliśmy dokładnie to samo wyszukiwanie

, za każdym razem wyświetlając inną odpowiedź, pochodzącą z różnych źródeł. Oznacza to, że użytkownicy otrzymują inną odpowiedź w zależności od tego, kiedy wyszukują, a to nie jest wystarczające - dodała.

Zaakceptuj pliki cookies Twitter/X, aby zobaczyć ten tweet.

Badacze sądzą także, że Przeglądy od AI dostarczają "całkowicie błędnych informacji" w przypadku wyszukiwani dotyczących diagnozowania

nowotworów piersi

u kobiet, lecz nie podali szczegółów sprawy. Uważają, że w wyniku kontaktu z takimi przekazami chorzy mogą zignorować niepokojące objawy.

Jak czytamy, nierzetelne informacje przedstawiano także w przypadku zapytań dotyczących

kryzysu zdrowia psychicznego

. Stephen Buckley, dyrektor ds. informacji w Mind, zaznaczył, że niektóre podsumowania zawierały "bardzo niebezpieczne porady" i były "niepoprawne, szkodliwe lub mogły sprawić, że ludzie unikaliby szukania pomocy".

Eksperci wykazali także, że

Przegląd od AI w swoich podsumowaniach często opiera się na źródłach "z nieodpowiednich stron"

, często powielając istniejące uprzedzenia, stereotypy lub mity medyczne. W niektórych przypadkach zaobserwowane zostały też stygmatyzujące narracje.

Jak podkreślono w tekście, śledztwo The Guardian jest następstwem rosnących obaw, że

AI może wprowadzać konsumentów w błąd

. Eksperci przywołali przy tej okazji wyniki listopadowego badania, które wykazało, że chatboty potrafią udzielać nieprecyzyjnych porad finansowych, a nawet niepoprawnie streszczać newsy.

Rzecznik Google, proszony przez The Guardian o udzielenie komentarza, stwierdził, że dostarczono mu "niekompletne zrzuty ekranu". Stwierdził, że w podsumowaniach zamieszczone zostały linki do "znanych, rzetelnych źródeł", wskazując, że zdecydowana większość Podsumowań od AI była "oparta na faktach" i "pomocna". Zapewnił też, że Google stale wprowadza ulepszenia jakości.

Zobacz też:

Hej, przypominamy tylko:

1. Szanujemy nawet ostrą dyskusję i wolność słowa, ale nie agresję. Przemocowe treści będą usuwane.

2. W komentarzach można swobodnie używać embedów z mediów społecznościowych.

3. Polecamy założenie konta, dzięki temu możesz zobaczyć wszystkie swoje dyskusje w jednym miejscu i dodać coś (👉 Sortownia), co trafi na stronę główną.

4. Jeżeli chcesz Donalda bez reklam, dołącz do naszych patronów: https://patronite.pl/donaldpl

Źródła:

2. https://twitter.com/Mayhem4Markets/status/2007245810527093167?s=20https://twitter.com/Mayhem4Markets/status/2007245810527093167?s=20

Pokaż więcej (2)Polecane posty z Sortowni

Popularne dzisiaj

Słowacja wprowadziła stan wyjątkowy bo zorientowali się, że są odcięci od ropy z Rosji

23

Ropa przestała płynąć na skutek rosyjskich ataków na ukraińską infrastrukturę. Zobacz więcej »

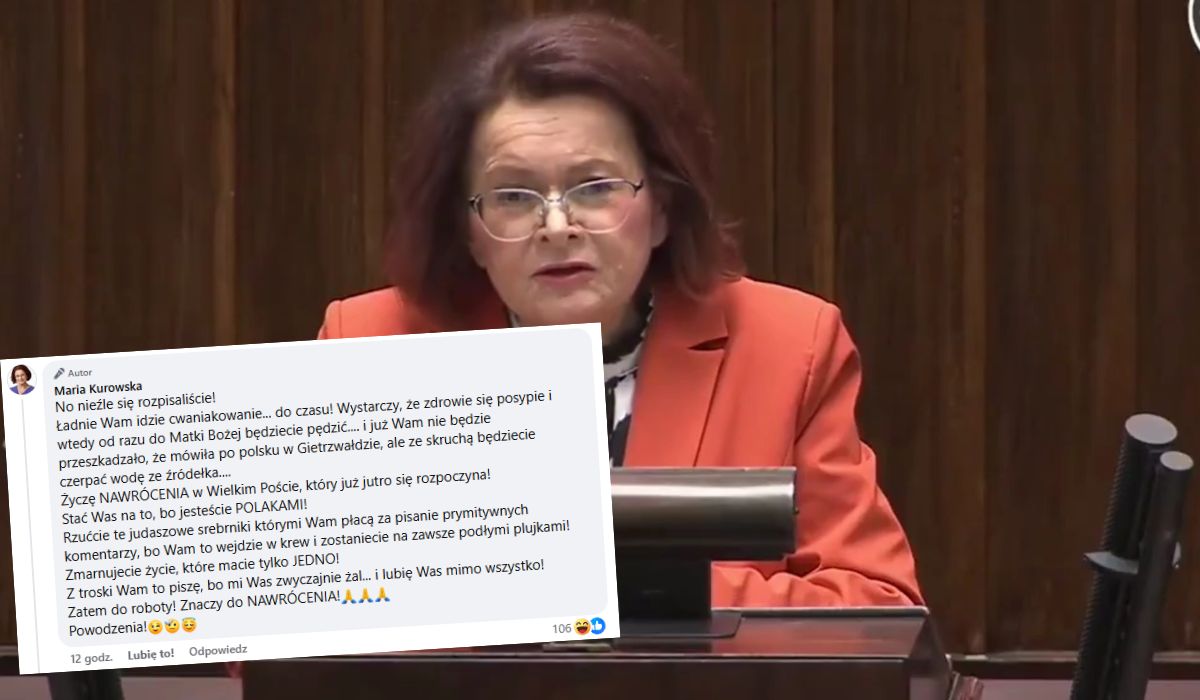

Posłanka PiS broni swojego zdania o tym, że Matka Boża mówiła po polsku

34

Maria Kurowska apelowała o stworzenie Sanktuarium Narodowego w Gietrzwałdzie. Zobacz więcej »

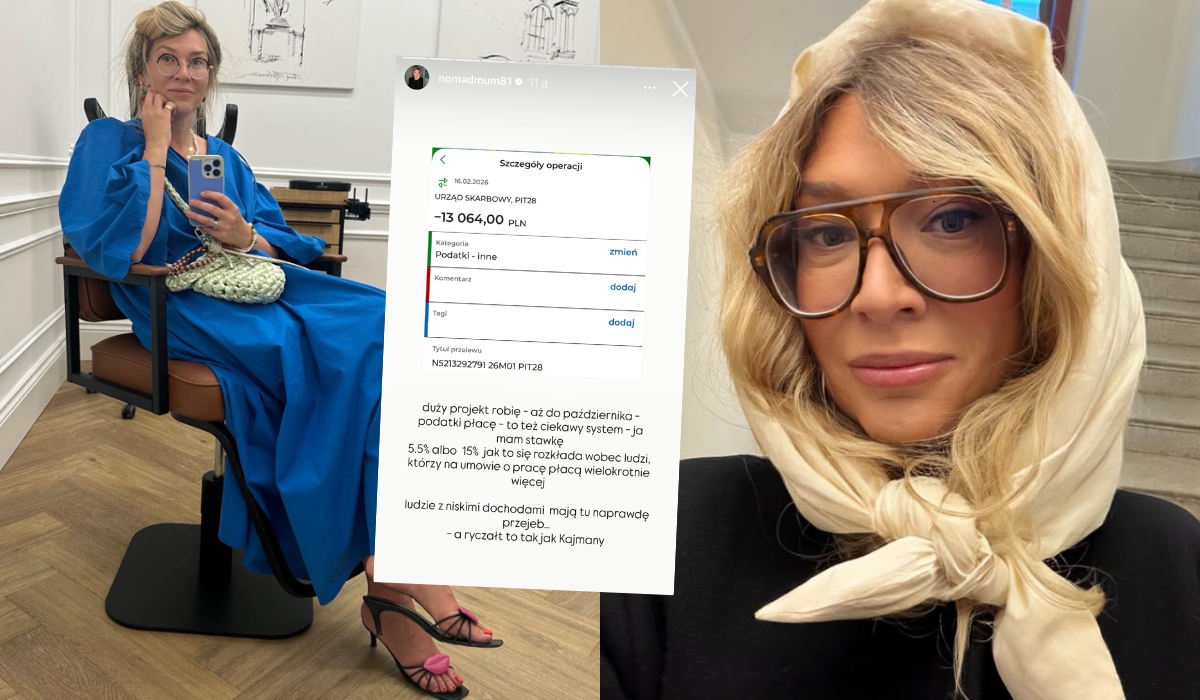

Influencerka pokazała, że dla niej i innych zamożnych osób podatki są bardzo łagodne

41

"Ludzie z niskimi dochodami mają tu naprawdę prz***ane", a ryczałt to tak jak Kajmany". Zobacz więcej »

Stanowski rozczarowany odejściem Wolskiego, nazywa go "dezerterem", który na wojnie zerwałby flagę i oddał karabin

24

Wolski w odpowiedzi zarzucił mu wypuszczanie "hołdu dla Putina". Zobacz więcej »