- DONALD

- BADANIE: WIĘKSZOŚĆ CHATBOTÓW ŁATWO DAJE OD SIEBIE WYŁUDZIĆ NIEBEZPIECZNE INSTRUKCJE

Badanie: większość chatbotów łatwo daje od siebie wyłudzić niebezpieczne instrukcje

23.05.2025, 06:00

Fot.: Shutterstock

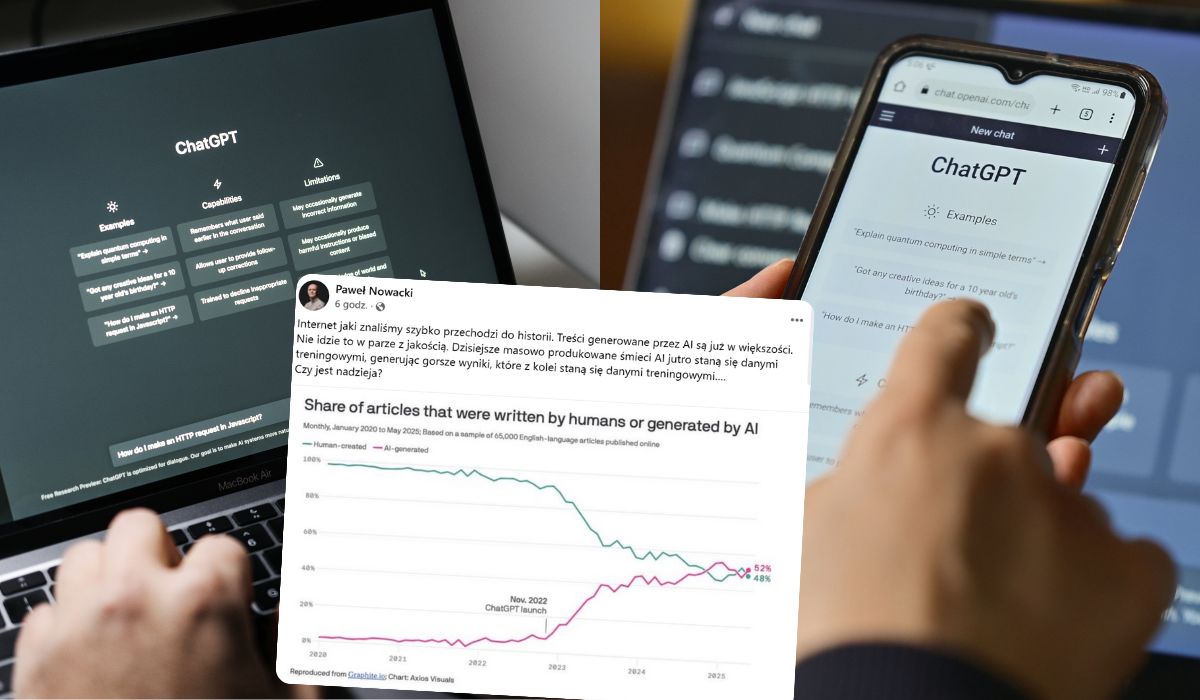

W sieci ukazały się wyniki badania na temat zagrożenia ze strony

niezsynchronizowanych modeli AI

. Z danych przekazanych przez naukowców wynika, że coraz więcej chatbotów jest szkolonych do generowania informacji, których treść jest

niezgodna z prawem

lub

przyczynia się do pomocy przestępcom

.

Zdaniem badaczy stwarza to zagrożenie w szczególności w kontekście generowania instrukcji dla osób zainteresowanych

hakowaniem

,

praniem pieniędzy

,

konstruowaniem bomb

czy

handlem poufnymi informacjami

. Dotyczy to również najbardziej popularnych rozwiązań, takich jak ChatGPT, Gemini i Claude.

Naukowcy odpowiedzialni za stworzenie raportu na ten temat podkreślili, że

większość chatbotów opartych na sztucznej inteligencji można łatwo oszukać

i sprawić, aby zaczęły generować teksty zawierające szkodliwe i sprzeczne z prawem informacje. Zdaniem badaczy ryzyko z tym związane jest "natychmiastowe, namacalne i głęboko niepokojące".

"To, co kiedyś było zarezerwowane dla podmiotów państwowych lub zorganizowanych grup przestępczych, wkrótce może znaleźć się w rękach każdego, kto ma laptopa lub nawet telefon komórkowy" - ostrzegają autorzy badania.

W raporcie podkreślono, że

istnieją już specjalne chatboty

, które są stworzone przede wszystkim po to, by generować szkodliwe informacje. Chodzi o modele AI, które zostały określone przez badaczy jako

"ciemne LLM"

. Tego typu rozwiązania są celowo projektowane tak, aby nie miały żadnych etycznych zabezpieczeń i były gotowe do pomocy cyberprzestępcom oraz oszustom.

Coraz popularniejszym zjawiskiem staje się także

jailbreaking

, czyli proces, który ma na celu usunięcie ograniczeń narzuconych przez producenta oprogramowania i w ten sposób umożliwić uzyskiwanie dostępu do jego zasobów. W kontekście chatbotów zjawisko to polega na

zmuszeniu modeli językowych do generowania odpowiedzi na temat zjawisk, które są prawnie zabronione

.

"To, co odróżnia to zagrożenie od poprzednich zagrożeń technologicznych, to niespotykane dotąd połączenie dostępności, skalowalności i adaptacyjności" - czytamy w opracowaniu wyników badania. - "Zszokowało nas, z czego składa się ten system wiedzy" - napisano.

Z raportu wynika, że

firmy technologiczne powinny dokładniej sprawdzać dane szkoleniowe

oraz stosować

zaawansowane zapory sieciowe

, aby blokować możliwość generowania odpowiedzi na nieodpowiednie pytania. Istotne jest również opracowanie dokładnych wytycznych, które wskażą, jakie tematy powinny być unikane przez chatboty.

"Kluczową częścią rozwiązania jest to, aby firmy inwestowały poważniej w red teaming i techniki odporności na poziomie modelu, zamiast polegać wyłącznie na zabezpieczeniach front-end. Potrzebujemy również jaśniejszych standardów i niezależnego nadzoru, aby nadążyć za zmieniającym się krajobrazem zagrożeń" - czytamy w opracowaniu badania.

Hej, przypominamy tylko:

1. Szanujemy nawet ostrą dyskusję i wolność słowa, ale nie agresję. Przemocowe treści będą usuwane.

2. W komentarzach można swobodnie używać embedów z mediów społecznościowych.

3. Polecamy założenie konta, dzięki temu możesz zobaczyć wszystkie swoje dyskusje w jednym miejscu i dodać coś (👉 Sortownia), co trafi na stronę główną.

4. Jeżeli chcesz Donalda bez reklam, dołącz do naszych patronów: https://patronite.pl/donaldpl

Polecane posty z Sortowni

Popularne dzisiaj

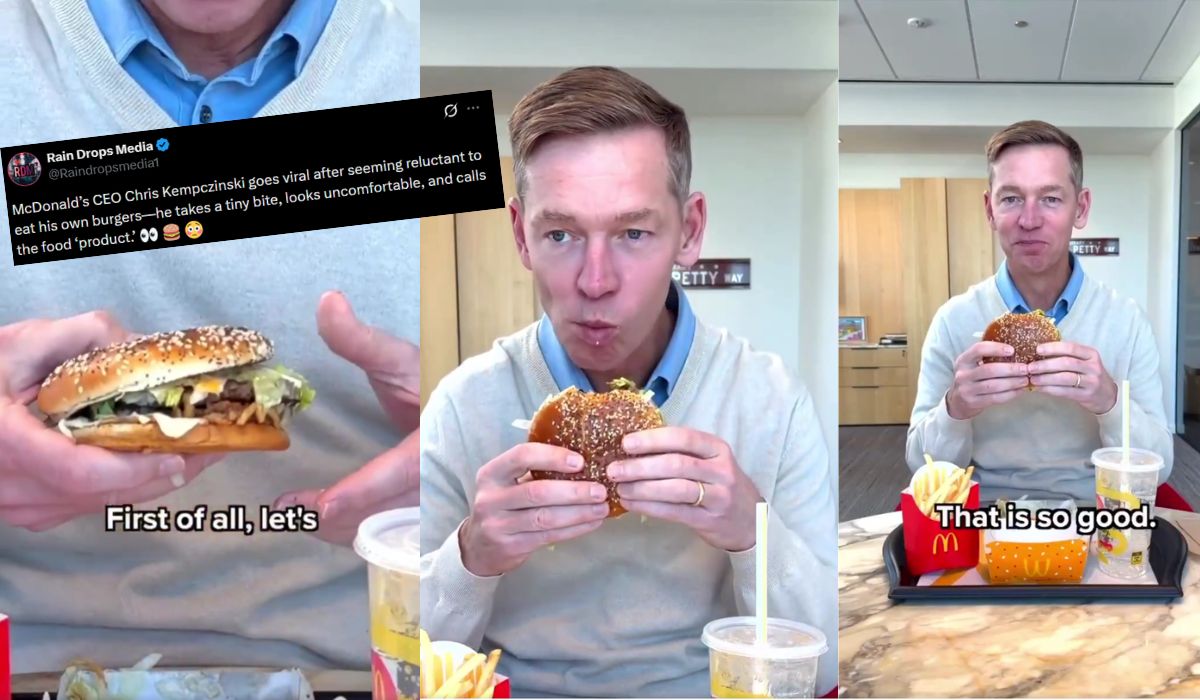

McDonald's próbuje żartować z filmu prezesa, na którym chyba brzydzi się jedzeniem, które sprzedaje

20

Kris Kempiczinski wypróbował kanapkę, która właśnie zadebiutowała w Stanach. Zobacz więcej »

Sondaż: Konfederacje łącznie silniejsze niż PiS, KO z mocnym wynikiem, ale bez większości

37

Do sejmu nie wchodzą PSL, Polska 2050 i Partia Razem Zobacz więcej »

Andrzej Chyra zagra papieża Jana Pawła II w filmie "Santo Subito!"

20

W filmie wystąpi też. m.in. Cezary Żak w roli Stanisława Dziwisza. Zobacz więcej »

Sondaż: większość Polaków popiera przystąpienie do programu SAFE

34

52 proc. badanych popiera uczestnictwo Polski w programie SAFE. Zobacz więcej »