- DONALD

- BIBLIOTEKARZE CORAZ CZĘŚCIEJ SĄ PYTANI O KSIĄŻKI ZMYŚLONE PRZEZ AI

Bibliotekarze coraz częściej są pytani o książki zmyślone przez AI

02.01.2026, 07:00

Fot. East News / Pixabay @jarmoluk / International Committee of the Red Cross

Międzynarodowy Komitet Czerwonego Krzyża,

organizacja, która zarządza jednymi z najczęściej wykorzystywanych archiwów naukowych na świecie, poinformowała, że coraz więcej dokumentów archiwalnych jest generowanych przez

sztuczną inteligencję

. Komitet ostrzega, że modele sztucznej inteligencji

są już w stanie tworzyć prace badawcze, czasopisma i archiwa

.

Organizacja opublikowała oświadczenie w tej sprawie. W dokumencie przekazano, że modele sztucznej inteligencji, takie jak ChatGPT, Gemini czy Copilot wprowadzają studentów, badaczy i archiwistów w błąd, generując

"nieprawidłowe lub sfabrykowane odniesienia archiwalne"

. Problematyczna okazuje się nie tylko kwestia fałszywych źródeł, ale również marnowanie czasu badaczy i bibliotekarzy, którzy poszukują nieistniejących tytułów. Zdaniem komitetu, modele AI mają generować nowe treści w oparciu o wzorce statystyczne i mogą w ten sposób tworzyć

wymyślone numery katalogowe

, opisy dokumentów, a nawet

odniesienia do platform, które nigdy nie istniały

. Członkowie organizacji zwracają uwagę na niebezpieczeństwo płynące z korzystania z wymyślonych źródeł.

"Szczególne ryzyko polega na tym, że narzędzia sztucznej inteligencji generatywnej

zawsze dostarczają odpowiedzi, nawet gdy źródła historyczne są niekompletne lub milczą

. Ponieważ ich celem jest generowanie treści, nie mogą one wskazywać, że nie ma żadnych informacji; zamiast tego będą wymyślać szczegóły, które wydają się prawdopodobne, ale nie mają oparcia w zapisach archiwalnych" - zaznaczają.

Międzynarodowy Komitet Czerwonego Krzyża apeluje, że brak odniesień do niektórych cytowań, nie oznacza, że Komitet ukrywa informacje przed czytelnikami.

"

Brak odniesień nie oznacza, że MKCK zataja informacje

. Można to wytłumaczyć różnymi sytuacjami, takimi jak niekompletne cytowania, dokumenty przechowywane w innych instytucjach lub - coraz częściej -

halucynacje generowane przez sztuczną inteligencję

. W takich przypadkach konieczne może być sprawdzenie historii administracyjnej odniesienia, aby ustalić, czy odpowiada ono autentycznemu źródłu archiwalnemu" - napisano w oświadczeniu.

W sprawie fałszywych treści generowanych przez AI głos zabrał również magazyn Scientific American, który opublikował artykuł, zamieszczając w nim rozmowę z Sarah Falls, szefową działu zaangażowania badaczy w Bibliotece Wirginii. Kobieta zdradziła dziennikarzom, że około 15 proc. wszystkich pytań referencyjnych, które otrzymują e-mailem, jest

generowanych przez chatboty

oparte na sztucznej inteligencji, takie jak ChatGPT. Dodatkowo niektóre wiadomości zawierają zmyślone przez AI cytaty zarówno opublikowanych prac, jak i unikalnych dokumentów źródłowych. Kobieta przekazała również, że ludzie mają nie wierzyć bibliotekarzom, gdy ci tłumaczą, że dany zapis nie istnieje.

Zobacz też:

Hej, przypominamy tylko:

1. Szanujemy nawet ostrą dyskusję i wolność słowa, ale nie agresję. Przemocowe treści będą usuwane.

2. W komentarzach można swobodnie używać embedów z mediów społecznościowych.

3. Polecamy założenie konta, dzięki temu możesz zobaczyć wszystkie swoje dyskusje w jednym miejscu i dodać coś (👉 Sortownia), co trafi na stronę główną.

4. Jeżeli chcesz Donalda bez reklam, dołącz do naszych patronów: https://patronite.pl/donaldpl

Źródła:

Pokaż więcej (1)Polecane posty z Sortowni

Popularne dzisiaj

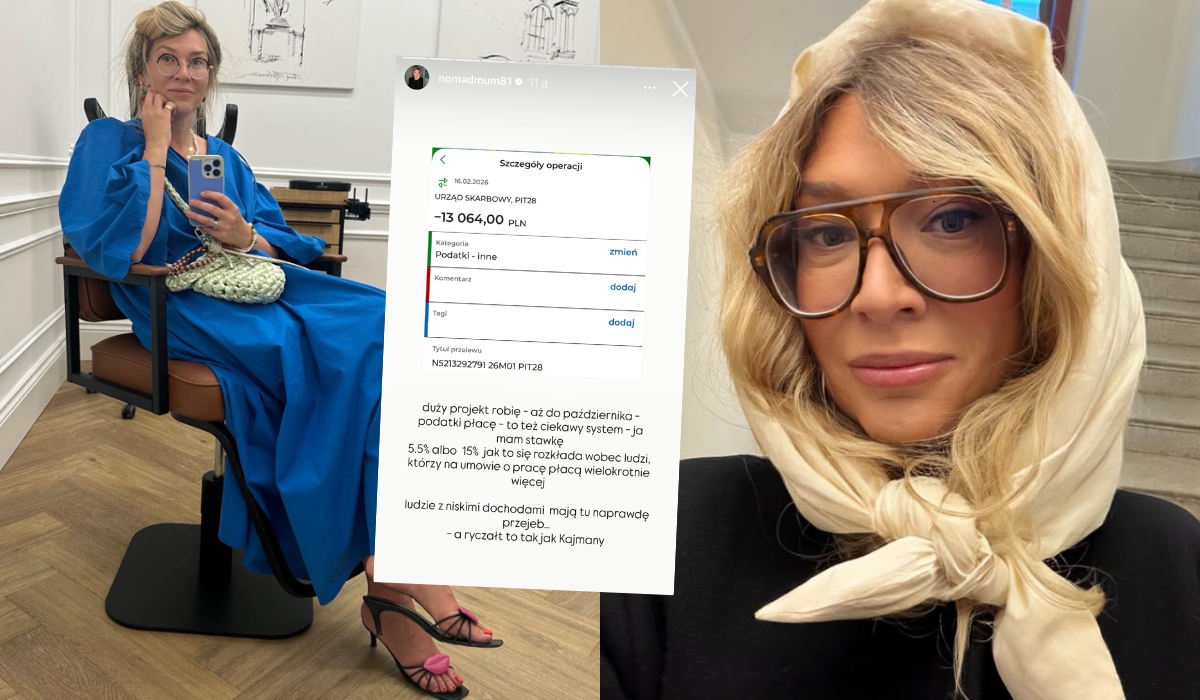

Influencerka pokazała, że dla niej i innych zamożnych osób podatki są bardzo łagodne

29

"Ludzie z niskimi dochodami mają tu naprawdę prz***ane", a ryczałt to tak jak Kajmany". Zobacz więcej »

Rozpad Polski 2050: frakcja Hennig-Kloski odchodzi i zakłada nowy klub parlamentarny

23

Wraz z nią z klubu odchodzą m.in. Ryszard Petru, Aleksandra Leo, Sławomir Ćwik i Rafał Kasprzyk. Zobacz więcej »

Premier krytykuje PiS i prezydenta za odrzucanie pożyczek na zbrojenia

39

"Nikt wam tego nie wybaczy". Zobacz więcej »

Pracownicy Dino alarmują, że ich koleżanka została zwolniona za zrobienie zdjęcia "posiłku regeneracyjnego"

24

"Kto zabroni bogatemu, kiedy państwo nie jest w stanie skutecznie chronić pracowników?". Zobacz więcej »